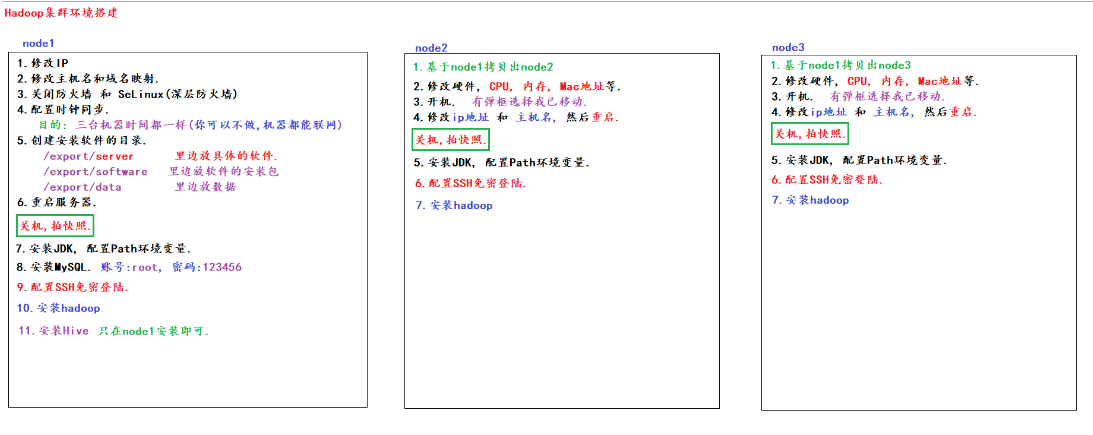

Linux搭建Hadoop集群环境

资料是我在网络上收集的,如有侵权请告知,我会第一时间删除

详细资料移步:阿里云盘

前期准备工作

友情提醒: 提前安装好vmware软件,准备好连接虚拟机的客户端

一. 基础环境 1.配置ip地址 1 [root@node1 /]# vim /etc/sysconfig/network-scripts/ifcfg-ens33

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 TYPE="Ethernet" PROXY_METHOD="none" BROWSER_ONLY="no" # 1.修改static BOOTPROTO="static" DEFROUTE="yes" IPV4_FAILURE_FATAL="no" IPV6INIT="yes" IPV6_AUTOCONF="yes" IPV6_DEFROUTE="yes" IPV6_FAILURE_FATAL="no" IPV6_ADDR_GEN_MODE="stable-privacy" NAME="ens33" UUID="dfd8991d-799e-46b2-aaf0-ed2c95098d58" DEVICE="ens33" ONBOOT="yes" # 2.添加以下内容 IPADDR="192.168.88.161" PREFIX="24" GATEWAY="192.168.88.2" NETMASK="255.255.255.0" DNS1="8.8.8.8" DNS2="114.114.114.114" IPV6_PRIVACY="no"

1 2 3 [root@node1 ~]# service network stop [root@node1 ~]# service network start [root@node1 ~]# service network restart

1 [root@node1 /]# ifconfig

2.配置主机名 1 [root@node1 ~]# vim /etc/hostname

3.禁用防火墙 1 2 [root@node1 ~]# systemctl stop firewalld.service [root@node1 ~]# systemctl disable firewalld.service

4.关闭Selinux 1 [root@node1 ~]# vim /etc/selinux/config

5.时钟同步 1 2 3 [root@node1 ~]# yum -y install ntpdate [root@node1 ~]# ntpdate ntp4.aliyun.com [root@node1 ~]# crontab -e

1 >*/1 * * * * /usr/sbin/ntpdate -u ntp4.aliyun.com

6.创建软件安装目录 1 2 3 [root@node1 ~] [root@node1 ~] [root@node1 export ]

7.配置域名映射 1 [root@node1 ~]# vim /etc/hosts

1 2 3 4 ># 文件内容如下: >192.168.88.161 node1.itcast.cn node1 >192.168.88.162 node2.itcast.cn node2 >192.168.88.163 node3.itcast.cn node3

8.重启系统 二. 安装jdk软件 1.上传软件

使用CRT等客户端远程上传资料中jdk-8u65-linux-x64.tar.gz文件到/export/software目录下

2.解压软件 1 2 [root@node1 ~]# cd /export/software/ [root@node1 software]# tar -zxvf jdk-8u65-linux-x64.tar.gz -C /export/server/

3.添加环境变量 1 [root@node1 software]# vim /etc/profile

1 2 3 >export JAVA_HOME=/export/server/jdk1.8.0_65 >export PATH=$PATH:$JAVA_HOME/bin >export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar

4.重新加载文件(配置生效) 1 [root@node1 software]# source /etc/profile

5.检查jdk版本 1 [root@node1 software]# java -version

三. 安装mysql软件 0.卸载mariadb-libs 1 [root@node1 software]# rpm -e --nodeps mariadb-libs

1.上传软件

使用CRT等客户端远程上传资料中mysql文件文件到/export/software目录下

2.解压软件 1 2 3 [root@node1 software]# mkdir /export/server/mysql5.7 [root@node1 software]# cd /export/software/mysql\ 5.7.29/ [root@node1 mysql 5.7.29]# tar -xvf mysql-5.7.29-1.el7.x86_64.rpm-bundle.tar -C /export/server/mysql5.7

3.安装mysql 1 2 [root@node1 mysql 5.7.29]# cd /export/server/mysql5.7/ [root@node1 mysql5.7]# rpm -ivh mysql-community-common-5.7.29-1.el7.x86_64.rpm mysql-community-libs-5.7.29-1.el7.x86_64.rpm mysql-community-client-5.7.29-1.el7.x86_64.rpm mysql-community-server-5.7.29-1.el7.x86_64.rpm

4.初始化服务 1 [root@node1 mysql5.7]# mysqld --initialize

5.修改文件拥有者和组 1 [root@node1 mysql5.7]# chown mysql:mysql /var/lib/mysql -R

6.启动mysql服务 1 [root@node1 mysql5.7]# systemctl start mysqld.service

7.设置开启自动启动 1 [root@node1 mysql5.7]# systemctl enable mysqld.service

8.查看mysql状态 1 [root@node1 mysql5.7]# systemctl status mysqld

9.登录mysql 1 2 3 [root@node1 mysql5.7]# Pass=$(grep 'A temporary password' /var/log/mysqld.log |awk '{print $NF}') [root@node1 mysql5.7]# mysql -uroot -p"$Pass"

10.修改root密码且授权远程访问 1 2 3 4 mysql> alter user user() identified by "123456"; mysql> use mysql; mysql> GRANT ALL PRIVILEGES ON *.* TO 'root'@'%' IDENTIFIED BY '123456' WITH GRANT OPTION; mysql> FLUSH PRIVILEGES;

四. 集群设置免密登录

克隆资料中node1虚拟机的前置条件:node1虚拟机存在且处于关闭状态

克隆虚拟机 1.node1虚拟机: 右键 -> “管理” -> “克隆”

2.图形化弹窗中: “下一页”选择”创建完整克隆”再”下一页”->填写: “node2” 并且选择对应位置”再点击”完成”

3.node2虚拟机: 右键 -> “设置” -> “NAT模式” -> “高级” -> “生成”Mac地址再’确定’ -> 最后点击”确定”

node2/3基础配置

1 [root@node1 /]# vim /etc/sysconfig/network-scripts/ifcfg-ens33

1 2 ># 注意此操作是在node2中修改ip地址 >IPADDR="192.168.88.102"

1 [root@node1 ~]# vim /etc/hostname

1 2 ># 注意此操作是在node2中修改主机名 >node2

1 [root@node2 ~]# ifconfig

设置免密登录

三台虚拟机都生成公钥和私钥

1 输入命令(注意需要三次回车操作) : ssh-keygen

分别拷贝公钥给其他虚拟机

1 2 3 输入命令(注意需要输入yes和密码) : ssh-copy-id node1 输入命令(注意需要输入yes和密码) : ssh-copy-id node1 去node2做 输入命令(注意需要输入yes和密码) : ssh-copy-id node1 去node3做

测试免密登录

1 2 3 输入命令(注意此时会直接登录成功) : ssh node1 输入命令(注意此时会直接登录成功) : ssh node2 输入命令(注意此时会直接登录成功) : ssh node3

五. 安装hadoop软件 1.上传软件

使用CRT等客户端远程上传资料中hadoop-3.3.0-Centos7-64-with-snappy.tar.gz文件到/export/software目录下

2.解压软件 1 2 [root@node1 ~]# cd /export/software/ [root@node1 software]# tar -zxvf hadoop-3.3.0-Centos7-64-with-snappy.tar.gz -C /export/server/

3.添加环境变量 1 [root@node1 software]# vim /etc/profile

1 2 >export HADOOP_HOME=/export/server/hadoop-3.3.0 >export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

1 [root@node1 server]# source /etc/profile

4.1修改配置文件[自动方式] 上传文件

使用CRT等客户端远程上传资料中配置好的文件压缩包 hadoop-config.tar文件到/export/software目录下

解压文件 1 2 [root@node1 ~]# cd /export/software/ [root@node1 software]# tar -xvf hadoop-config.tar -C /export/server/

覆盖原有文件 1 2 [root@node1 software]# mv -f /export/server/hadoop-config/* /export/server/hadoop-3.3.0/etc/hadoop/ [root@node1 software]# rm -rf /export/server/hadoop-config*

4.2配置文件详解[手动方式] ①hadoop-env.sh文件 1 [root@node1 hadoop]# vim hadoop-env.sh

1 2 3 4 5 6 7 8 > >export JAVA_HOME=/export/server/jdk1.8.0_65 > >export HDFS_NAMENODE_USER=root >export HDFS_DATANODE_USER=root >export HDFS_SECONDARYNAMENODE_USER=root >export YARN_RESOURCEMANAGER_USER=root >export YARN_NODEMANAGER_USER=root

② core-site.xml文件 1 [root@node1 hadoop]# vim core-site.xml

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 > > ><property > <name > fs.defaultFS</name > <value > hdfs://node1:8020</value > ></property > > ><property > <name > hadoop.tmp.dir</name > <value > /export/data/hadoop-3.3.0</value > ></property > > ><property > <name > hadoop.http.staticuser.user</name > <value > root</value > ></property > > ><property > <name > hadoop.proxyuser.root.hosts</name > <value > *</value > ></property > ><property > <name > hadoop.proxyuser.root.groups</name > <value > *</value > ></property > > ><property > <name > fs.trash.interval</name > <value > 1440</value > ></property >

③ hdfs-site.xml文件 1 [root@node1 hadoop]# vim hdfs-site.xml

1 2 3 4 5 6 > <property > <name > dfs.namenode.secondary.http-address</name > <value > node2:9868</value > </property >

④ mapred-site.xml文件 1 [root@node1 hadoop]# vim mapred-site.xml

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 > <property > <name > mapreduce.framework.name</name > <value > yarn</value > </property > <property > <name > mapreduce.jobhistory.address</name > <value > node1:10020</value > </property > <property > <name > mapreduce.jobhistory.webapp.address</name > <value > node1:19888</value > </property > <property > <name > yarn.app.mapreduce.am.env</name > <value > HADOOP_MAPRED_HOME=${HADOOP_HOME}</value > </property > <property > <name > mapreduce.map.env</name > <value > HADOOP_MAPRED_HOME=${HADOOP_HOME}</value > </property > <property > <name > mapreduce.reduce.env</name > <value > HADOOP_MAPRED_HOME=${HADOOP_HOME}</value > </property >

⑤ yarn-site.xml文件 1 [root@node1 hadoop]# vim yarn-site.xml

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 > <property > <name > yarn.resourcemanager.hostname</name > <value > node1</value > </property > <property > <name > yarn.nodemanager.aux-services</name > <value > mapreduce_shuffle</value > </property > <property > <name > yarn.nodemanager.pmem-check-enabled</name > <value > false</value > </property > <property > <name > yarn.nodemanager.vmem-check-enabled</name > <value > false</value > </property > <property > <name > yarn.log-aggregation-enable</name > <value > true</value > </property > <property > <name > yarn.log.server.url</name > <value > http://node1:19888/jobhistory/logs</value > </property > <property > <name > yarn.log-aggregation.retain-seconds</name > <value > 604800</value > </property >

⑥ workers文件 1 [root@node1 hadoop]# vim workers

1 2 3 4 ># 用以下内容把之前内容覆盖 >node1 >node2 >node3

5.拷贝软件到其他机器

nod1主机上拷贝到node2和node3中各一份

1 [root@node1 server]# scp -r /export/server/hadoop-3.3.0 root@node2:/export/server/

1 2 3 [root@node2 server]# echo 'export HADOOP_HOME=/export/server/hadoop-3.3.0' >> /etc/profile [root@node2 server]# echo 'export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin' >> /etc/profile [root@node2 server]# source /etc/profile

6.hadoop集群启动 ① 数据初始化 ②单节点逐个启动[了解] 启动HDFS集群

在主节点上使用以下命令启动HDFS NameNode

1 [root@node1 ~]# hdfs --daemon start namenode

在每个从节点上使用以下命令启动HDFS DataNode

1 [root@node2 ~]# hdfs --daemon start datanode

1 [root@node3 ~]# hdfs --daemon start datanode

node2上使用以下命令启动HDFS SecondaryNameNode

1 [root@node2 ~]# hdfs --daemon start secondarynamenode

启动YARN集群

③单个集群启动和关闭[了解] 1 2 3 4 5 [root@node1 ~]# stop-dfs.sh [root@node1 ~]# stop-yarn.sh [root@node1 ~]# start-dfs.sh [root@node1 ~]# start-yarn.sh

④jps查看进程 1 2 3 [root@node1 ~]# jps [root@node2 ~]# jps [root@node3 ~]# jps

⑤一键启动和关闭[重点] 1 2 3 [root@node1 ~]# stop-all.sh [root@node1 ~]# start-all.sh

⑥启动jobHistory服务[重点] 1 [root@node1 ~]# mapred --daemon start historyserver

[了解]hadoop shell 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 [root@node1 ~]# hdfs dfs -ls / [root@node1 ~]# hdfs dfs -mkdir /binzi [root@node1 ~]# hdfs dfs -touch /binzi/1.txt /binzi/2.txt [root@node1 ~]# hdfs dfs -ls /binzi [root@node1 ~]# hdfs dfs -mv /binzi /binzi2 [root@node1 ~]# hdfs dfs -cp /binzi2 /binzi3 [root@node1 ~]# echo hello binzi > a.txt [root@node1 ~]# hdfs dfs -put /root/a.txt /binzi [root@node1 ~]# hdfs dfs -cat /binzi/a.txt [root@node1 ~]# hdfs dfs -get /binzi/a.txt / [root@node1 ~]# hdfs dfs -rm /binzi/2.txt [root@node1 ~]# hdfs dfs -rm -r /binzi [root@node1 ~]# hdfs dfs -ls / [root@node1 ~]# hdfs dfs 回车

六. 集群web-ui[重点] 一旦Hadoop集群启动并运行,可以通过web-ui进行集群查看,如下所述:

访问HDFS的NameNode主机 : http://192.168.88.101:9870/

访问YARN的ResourceManager主机 : http://192.168.88.101:8088/

注意: 想要上传文件夹需要配置本地域名映射

本地配置域名映射

1 2 3 >192.168.88.101 node1.itcast.cn node1 >192.168.88.102 node2.itcast.cn node2 >192.168.88.103 node3.itcast.cn node3

配置完成后,可以直接通过node1访问

HDFS: http://node1:9870/

YARN: http://node1:8088/

jobhistory: http://node1:19888/jobhistory

七. 安装hive软件 1.上传软件

使用CRT等客户端远程上传资料中 apache-hive-3.1.2-bin.tar.gz 文件到/export/software目录下

2.解压软件 1 2 [root@node1 software]# cd /export/software/ [root@node1 software]# tar -zxvf apache-hive-3.1.2-bin.tar.gz -C /export/server/

3.解决Hive与Hadoop之间guava版本差异 1 2 [root@node1 software]# rm -rf /export/server/apache-hive-3.1.2-bin/lib/guava-19.0.jar [root@node1 software]# cp /export/server/hadoop-3.3.0/share/hadoop/common/lib/guava-27.0-jre.jar /export/server/apache-hive-3.1.2-bin/lib/

4.添加环境变量 1 [root@node1 software]# vim /etc/profile

1 2 >export HIVE_HOME=/export/server/apache-hive-3.1.2-bin >export PATH=$PATH:$HIVE_HOME/bin:$HIVE_HOME/sbin

1 [root@node1 server]# source /etc/profile

5.修改配置文件 ①hive-env.sh

修改文件名称

1 2 [root@node1 software]# cd /export/server/apache-hive-3.1.2-bin/conf [root@node1 conf]# mv hive-env.sh.template hive-env.sh

打开文件写入数据

1 [root@node1 conf]# vim hive-env.sh

1 2 3 >export HADOOP_HOME=/export/server/hadoop-3.3.0 >export HIVE_CONF_DIR=/export/server/apache-hive-3.1.2-bin/conf >export HIVE_AUX_JARS_PATH=/export/server/apache-hive-3.1.2-bin/lib

②hive-site.xml

打开文件写入数据

1 [root@node1 conf]# vim hive-site.xml

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 ><configuration > > ><property > ><name > javax.jdo.option.ConnectionURL</name > ><value > jdbc:mysql://node1:3306/hive3?createDatabaseIfNotExist=true& useSSL=false</value > ></property > ><property > ><name > javax.jdo.option.ConnectionDriverName</name > ><value > com.mysql.jdbc.Driver</value > ></property > ><property > ><name > javax.jdo.option.ConnectionUserName</name > ><value > root</value > ></property > ><property > ><name > javax.jdo.option.ConnectionPassword</name > ><value > 123456</value > ></property > > ><property > ><name > hive.server2.thrift.bind.host</name > ><value > node1</value > ></property > > ><property > ><name > hive.metastore.uris</name > ><value > thrift://node1:9083</value > ></property > > ><property > ><name > hive.metastore.event.db.notification.api.auth</name > ><value > false</value > ></property > ></configuration >

6.上传mysql驱动

使用夯哥提供的CRT等客户端远程上传夯哥资料中mysql-connector-java-5.1.32.jar到 /export/server/apache-hive-3.1.2-bin/lib下

7.初始化元数据 1 2 [root@node1 mysql 5.7.29]# cd /export/server/apache-hive-3.1.2-bin/ [root@node1 apache-hive-3.1.2-bin]# schematool -initSchema -dbType mysql -verbos

8.在hdfs创建hive存储目录 1 2 3 4 [root@node1 apache-hive-3.1.2-bin]# hdfs dfs -mkdir /tmp [root@node1 apache-hive-3.1.2-bin]# hadoop fs -mkdir -p /user/hive/warehouse [root@node1 apache-hive-3.1.2-bin]# hadoop fs -chmod g+w /tmp [root@node1 apache-hive-3.1.2-bin]# hadoop fs -chmod g+w /user/hive/warehouse

9.启动hive服务[重点]

启动metastore服务

1 2 3 4 # 前台启动(一般不用) [root@node1 apache-hive-3.1.2-bin]# hive --service metastore [root@node1 apache-hive-3.1.2-bin]# hive --service metastore --hiveconf hive.root.logger=DEBUG,console

1 2 3 4 5 6 7 # 后台启动 回车后进程挂起 关闭使用jps+ kill -9 [root@node1 apache-hive-3.1.2-bin]# nohup hive --service metastore & [root@node1 apache-hive-3.1.2-bin]# hive # 直接输入show databases;查看表 hive> show databases; # 结果OK default...说明成功

启动hiveserver2服务

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 [root@node1 apache-hive-3.1.2-bin]# nohup hive --service metastore & [root@node1 apache-hive-3.1.2-bin]# nohup hive --service hiveserver2 & [root@node1 apache-hive-3.1.2-bin]# beeline # 先输入!connect jdbc:hive2://node1:10000连接 beeline> !connect jdbc:hive2://node1:10000 # 再输入用户名root,密码不用输入直接回车即可 Enter username for jdbc:hive2://node1:10000: root Enter password for jdbc:hive2://node1:10000: # 输入show databases;查看表 0: jdbc:hive2://node1:10000> show databases; # 结果OK default...说明成功

八. 安装zookeeper软件 1.上传软件

使用CRT等客户端远程上传资料中zookeeper-3.4.6.tar.gz 文件到/export/software目录下

2.解压软件 1 2 3 4 [root@node1 ~]# cd /export/software/ [root@node1 software]# tar -zxvf zookeeper-3.4.6.tar.gz -C /export/server/ [root@node1 software]# cd /export/server/ [root@node1 server]# mv zookeeper-3.4.6 zookeeper

3.添加环境变量 1 [root@node1 server]# vim /etc/profile

1 2 >export ZOOKEEPER_HOME=/export/server/zookeeper >export PATH=$PATH:$ZOOKEEPER_HOME/bin

1 [root@node1 server]# source /etc/profile

4.创建数据目录添加myid值为1 1 2 [root@node1 server]# mkdir -p /export/server/zookeeper/zkdatas/ [root@node1 server]# echo 1 > /export/server/zookeeper/zkdatas/myid

5.修改配置文件 1 2 3 [root@node1 server]# cd /export/server/zookeeper/conf/ [root@node1 conf]# cp zoo_sample.cfg zoo.cfg [root@node1 conf]# vim zoo.cfg

1 2 3 4 5 6 ># 修改数据存放目录 >dataDir=/export/server/zookeeper/zkdatas ># 添加集群中服务地址 >server.1=node1:2888:3888 >server.2=node2:2888:3888 >server.3=node3:2888:3888

6.拷贝到软件到其他机器

nod1主机上拷贝到node2和node3中各一份

1 2 3 [root@node1 conf]# cd /export/server/ [root@node1 server]# scp -r /export/server/zookeeper/ node2:/export/server/ [root@node1 server]# scp -r /export/server/zookeeper/ node3:/export/server/

1 2 3 4 5 [root@node2 ~]# echo 2 > /export/server/zookeeper/zkdatas/myid # 配置环境变量 [root@node2 ~]# echo 'export ZOOKEEPER_HOME=/export/server/zookeeper' >> /etc/profile [root@node2 ~]# echo 'export PATH=$PATH:$ZOOKEEPER_HOME/bin' >> /etc/profile [root@node2 ~]# source /etc/profile

7.zookeeper服务启动 如下命令三台服务器均可操作: stop:停止 start:开启 status:状态

可以使用crt发送交互到所有会话

1 2 3 4 5 6 [root@node123 bin]# zkServer.sh start [root@node123 bin]# zkServer.sh status [root@node123 bin]# zkServer.sh stop

8.命令jps查看进程 1 2 3 [root@node1 ~]# jps [root@node2 ~]# jps [root@node3 ~]# jps

九. Hadoop高可用环境搭建

确定提前安装好了hadoop和zookeeper

1.删除原有数据文件

三台机器都要进行删除

1 rm -rf /export/data/hadoop-3.3.0

2.安装软件

三台机器都要进行安装

3.修改配置文件

先只修改node1,最后拷贝给其他机器

进入hadoop目录 1 2 [root@node1 /]# cd /export/server/hadoop-3.3.0/etc/hadoop/ [root@node1 hadoop]# ls

修改hadoop-env.sh

1 2 >export HDFS_JOURNALNODE_USER=root >export HDFS_ZKFC_USER=root

修改core-site.xml

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 ><configuration > > ><property > <name > fs.defaultFS</name > <value > hdfs://cluster1</value > </property > ><property > <name > hadoop.tmp.dir</name > <value > /export/data/ha-hadoop</value > </property > ><property > <name > ha.zookeeper.quorum</name > <value > node1:2181,node2:2181,node3:2181</value > </property > ><property > <name > hadoop.proxyuser.root.hosts</name > <value > *</value > </property > <property > <name > hadoop.proxyuser.root.groups</name > <value > *</value > </property > </configuration >

修改hdfs-site.xml

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 ><configuration > > ><property > <name > dfs.nameservices</name > <value > cluster1</value > </property > ><property > <name > dfs.ha.namenodes.cluster1</name > <value > nn1,nn2</value > </property > ><property > <name > dfs.namenode.rpc-address.cluster1.nn1</name > <value > node1:8020</value > </property > ><property > <name > dfs.namenode.http-address.cluster1.nn1</name > <value > node1:50070</value > </property > ><property > <name > dfs.namenode.rpc-address.cluster1.nn2</name > <value > node2:8020</value > </property > ><property > <name > dfs.namenode.http-address.cluster1.nn2</name > <value > node2:50070</value > </property > ><property > <name > dfs.namenode.shared.edits.dir</name > <value > qjournal://node1:8485;node2:8485;node3:8485/cluster1</value > </property > ><property > <name > dfs.journalnode.edits.dir</name > <value > /export/data/journaldata</value > </property > ><property > <name > dfs.ha.automatic-failover.enabled</name > <value > true</value > </property > ><property > <name > dfs.client.failover.proxy.provider.cluster1</name > <value > org.apache.hadoop.hdfs.server.namenode.ha.ConfiguredFailoverProxyProvider</value > </property > ><property > <name > dfs.ha.fencing.methods</name > <value > sshfence</value > </property > ><property > <name > dfs.ha.fencing.ssh.private-key-files</name > <value > /root/.ssh/id_rsa</value > </property > ><property > <name > dfs.ha.fencing.ssh.connect-timeout</name > <value > 30000</value > </property > </configuration >

修改yarn-site.xml

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 ><configuration > > ><property > <name > yarn.resourcemanager.ha.enabled</name > <value > true</value > </property > <property > <name > yarn.resourcemanager.cluster-id</name > <value > yrc</value > </property > <property > <name > yarn.resourcemanager.ha.rm-ids</name > <value > rm1,rm2</value > </property > <property > <name > yarn.resourcemanager.hostname.rm1</name > <value > node1</value > </property > <property > <name > yarn.resourcemanager.hostname.rm2</name > <value > node2</value > </property > <property > <name > yarn.resourcemanager.zk-address</name > <value > node1:2181,node2:2181,node3:2181</value > </property > <property > <name > yarn.nodemanager.aux-services</name > <value > mapreduce_shuffle</value > </property > </configuration >

拷贝给node2 1 scp -r /export/server/hadoop-3.3.0/ node2:/export/server/

拷贝给node3 1 scp -r /export/server/hadoop-3.3.0/ node3:/export/server/

4.启动高可用服务

注意:一定要按照以下的顺序进行启动

启动Zookeeper服务 启动journalnode服务

三台机器都要启动

1 hadoop-daemon.sh start journalnode

初始化 namenode

先在node1上执行初始化

1 2 3 [root@node1 data]# hdfs namenode -format [root@node1 data]# ls ha-hadoop journaldata

将初始化生成的目录,复制到 node2 下

1 [root@node1 data]# scp -r /export/data/ha-hadoop/ node2:/export/data/

启动zkfc服务

注意: 要在 node1 上进行启动

1 [root@node1 data]# hdfs zkfc -formatZK

启动hadoop服务

注意: 要在node1 上进行启动

DFSZKFailoverController服务真正是hadoop启动起来的

1 [root@node1 data]# start-all.sh

查看所有服务 5.web页面查看 1 2 hdfs服务 : 192.168.88.101:50070 192.168.88.102:50070 yarn服务 : 192.168.88.101:8088 192.168.88.102:8088